Clonar las voces de altos funcionarios con IA es peligrosamente fácil, ¿qué hacer?

Discursos de odio, noticias falsas, abusos, cumplidos, chistes, y un sinfín de discursos pueden ser dichos por cualquier alto funcionario mexicano. O al menos la Inteligencia Artificial puede hacer que eso parezca sin ningún tipo de filtro de seguridad que controle el contenido generado.

A partir de un pago y unos cuantos clics la Inteligencia Artificial (IA) puede generar casi cualquier tipo de discurso con una calidad que podría confundir y engañar por la imperceptibilidad de sus errores.

A través de una investigación, Arena Pública analizó dos de las principales plataformas de generación de voz con inteligencia artificial para examinar cuál era el procedimiento para la clonación de las voces de cuatro personajes de la política y economía mexicana: Claudia Sheinbaum, virtual presidenta electa de México; Guadalupe Taddei, presidenta del Instituto Nacional Electoral (INE); Victoria Rodríguez Ceja, Gobernadora del Banco de México; y Rogelio Ramírez de la O, secretario de Hacienda y Crédito Público.

Las voces de los funcionarios públicos se clonaron a partir de cuatro diferentes discursos. El hallazgo fue que en ninguna de las dos plataformas hay requerimientos significativos para clonar los diferentes tipos de discurso, aún cuando contengan discursos obscenos, abusivos, de odio, o noticias falsas.

Este panorama cobra relevancia después de que en el periodo electoral se difundiera contenido generado con Inteligencia Artificial a diestra y siniestra. En al menos tres ocasiones, la virtual presidenta electa tuvo que desmentir las declaraciones difundidas, entre ellas, un video en el que se le podía escuchar hablando en ruso, mismo que acompañaron con símbolos de la lucha comunista.

En otra ocasión, también tuvo que verificarse un video de la candidata donde promocionaba productos financieros. Las imágenes y audios creados con Inteligencia Artificial, según expertos citados por Reuters, agencia de noticias que verificó el caso, utilizaron un video del canal de YouTube de la candidata para promocionar plataformas de inversión bursátil.

Pero este no es un caso aislado, pues a través de la red social Facebook también se compartió un video de una noticia falsa, donde aparecía el presidente Andrés Manuel López Obrador en una supuesta conferencia mañanera, donde presentaba un proyecto en el que los mexicanos recibirían un dividendo cada semana.

Este tipo de contenido falso, también llamado deepfake, manipula el contenido a modo y tiene graves riesgos de desinformación. Esta tecnología no solo tiene el potencial de crear contenido falso para influir en los votos en periodos electorales, sino que también puede emplearse para producir mensajes falsos sobre temas clave o sensibles impactando directamente en la percepción pública. Por ejemplo, ¿qué certeza tiene un inversionista de que un audio, en el que se escucha la voz del secretario de Hacienda, es real?

Dichas herramientas también facilitan la creación de estafas o mensajes falsos, especialmente teniendo en cuenta que el 70% de la población mexicana no sabe qué es un deepfake, según datos de Kaspersky, empresa especializada en ciberseguridad, a través de su encuesta “La infodemia y su impacto en la vida digital”.

No por nada OpenAI retrasó el lanzamiento de su modelo Voice Engine, diseñado para crear voces sintéticas a partir de instrucciones escritas utilizando solo un segmento de 15 segundos de audio grabado. La empresa creadora de ChatGPT aún no está lista para lanzar esta tecnología de manera generalizada debido a las implicaciones éticas.

Como lo describe José Gustavo Fuentes, líder técnico en ciencia de datos y experto en Inteligencia Artificial, las clonaciones de voz juegan un papel importante en la manipulación. “Puedes acceder a un abanico de herramientas de manipulación mediática que pueden poner en juego la reputación e imagen de una persona. Qué peligroso puede ser que se manipule a una persona, por ejemplo en el caso de la voz de un gobernante que se manipule lo que dice para generar discursos de odio. Podría generar desinformación con fines políticos”, explica.

La tecnología de clonación de voz no es particularmente nueva: desde 2022 hemos visto varios modelos de síntesis de voz de IA, y ha estado activa en la comunidad de código abierto con paquetes como OpenVoice y XTTSv2. Sin embargo, la facilidad con la que se pueden crear estos audios y la gran fidelidad que tienen para emular el comportamiento humano es algo que no se había visto hasta hace algunos meses.

En México, el problema es el mismo que alrededor del mundo: la regulación no es clara y es insuficiente para acaparar este tipo de herramientas. Sin embargo, a diferencia de los países en los que esta tecnología se está desarrollando de manera más rápida como en Estados Unidos o en Europa, en el territorio mexicano son menos las plataformas que permiten la clonación de voz en español.

El experimento

Arena Pública analizó ElevenLabs y Speechify Studio, dos plataformas que permiten clonar voces y reproducirlas en español.

Fundada en 2022, ElevenLabs es reconocida como una de las principales plataformas de clonación de voz a partir de aprendizaje profundo, aunque su uso no se limita a esa herramienta, pues también funciona como conversor de texto a voz con banco de voces. Aunque Speechify también posee estas herramientas, adicionalmente funciona como transcriptor.

Para acceder a la clonación, ElevenLabs requiere que el usuario se registre y tenga una suscripción activa. La página tiene cinco planes distintos: Gratis, Inicio, Creador, Pro y Escala. Todos los planes de paga permiten acceder a la clonación rápida, desde el paquete inicial con un precio de sólo 5 dólares, es decir, alrededor de 90 pesos mexicanos. No obstante, si se busca acceder a la clonación profesional, que logra “crear la réplica digital más realista de tu voz”, según la empresa, se necesita contratar el paquete Creador, con un precio de 22 dólares (aunque el primer mes cuesta sólo 11 dólares), cerca de 400 pesos mexicanos (o 200 pesos el primer mes).

A diferencia de la clonación rápida, la clonación profesional requiere de al menos 30 minutos de la voz original que se busca replicar y puede ser alimentada con hasta 3 horas de contenido en audio para lograr “entrenar” mejor la herramienta.

En Speechify, a diferencia de ElevenLabs, se requirió un pago de 598.28 pesos mexicanos, aunque existen dos planes más básicos, pero que no incluyen la clonación de voz. De igual manera es necesaria la creación de una cuenta a partir de un correo electrónico y contraseña.

Posterior a realizar el pago, las dos aplicaciones cuyo idioma principal es el inglés, despliegan un menú en el que se encuentra la herramienta de clonación de voz. Para realizarla, no hay que hacer nada más que agregar un audio de la voz original, pues las plataformas no presentan filtros en clonaciones de voz no avanzada.

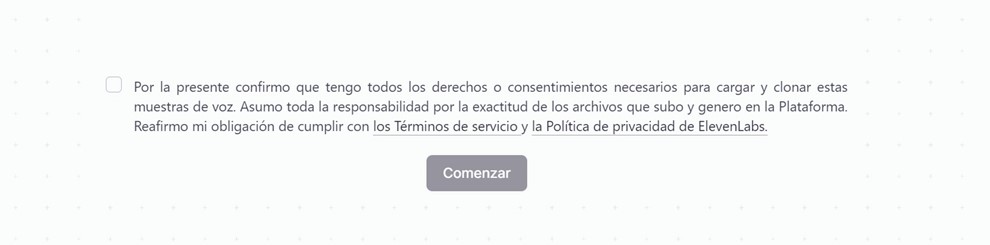

Para ambas plataformas, la antesala únicamente es un aviso de privacidad, en el que con un clic se acepta que se tiene el consentimiento para el uso y clonación del material proporcionado.

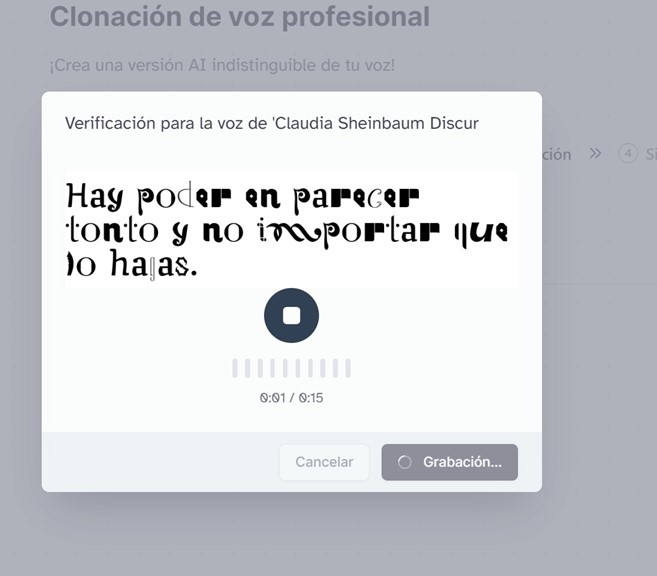

En el caso de la clonación profesional de ElevenLabs, la cual se entrena con al menos media hora de audio para obtener una copia más fiel a la original, sí se tiene un filtro de seguridad más amplio, en el que se necesita que la persona autora de la voz replique un texto en quince segundos inmediatos a la importación.

Este filtro no puede burlarse tan fácilmente, pues el texto contiene palabras con una tipografía distinta a la usual en formato de imagen, por lo que no es posible copiarlo, además de que hay poco tiempo como margen. A los 15 segundos, la frase que se debe repetir cambia, y tras 5 intentos fallidos, el sistema elimina la opción de verificar esa voz.

Arena Pública trató distintos métodos para intentar burlar el sistema sin éxito.

Sin embargo, el contraste en seguridad con su herramienta de clonación rápida es notorio. Arena Pública la utilizó para clonar las voces de los cuatro personajes, sin mayor complicación y en menos de 2 minutos.

Para el caso de Speechify Lab, la ejecución no tiene ningún tipo de filtro más allá de una aceptación de términos y condiciones, por lo que la clonación pudo llevarse a cabo en los diferentes tipos de discursos proporcionados al generador.

Hallazgos

De ambas plataformas se obtuvieron un total de cuarenta audios clonados: veinte por cada una. En la mayoría de los casos, las clonaciones no presentaron problemas de dicción o de generación, de manera que al menos 31 tienen una calidad legible para el escucha, sin problemas o errores de pronunciación. Es decir, el 80% de los audios tienen calidad promedio para la escucha.

El 7.5% de los audios tienen algún defecto en la acentuación o la dicción de palabras; el mismo porcentaje aplica para los problemas de generación, en los que la plataforma generó sonidos sin sentido antes de decir el texto deseado, cortó palabras o intervienen de más los silencios.

Un 5% tuvo problemas de pronunciación de acuerdo al idioma, ya que para la plataforma de Speechify Lab, la clonación de voz no permite elegir el idioma en audios subidos a través del ordenador. En ningún caso el desarrollo no pudo generar el audio.

Los audios de mayor calidad son los proporcionados por ElevenLabs, que se lograron a partir de una muestra de entre 5 y 8 minutos de audio cargado (aunque es posible hacer clonación con apenas un minuto de audio). Los audios proporcionados por Speechify Lab, si bien son de menor calidad, y de menor fidelidad, logran en algunas veces el parecido a la voz original.

Los discursos de odio incluían palabras altisonantes, racistas y clasistas diferentes para los cuatro personajes, y tenían una extensión promedio de 18 palabras cada uno. Las noticias falsas se basaron en noticias reales de la coyuntura nacional actual, y su extensión era más larga, de 30 palabras en promedio. Para los discursos amables se incluyeron chistes, palabras de aliento o consejos, de una extensión de 25 palabras en promedio. Además, se incluyeron discursos verdaderos, es decir, que los personajes sí dijeron para comparar la fidelidad de los audios.

En las pruebas realizadas, se pudo clonar fácilmente la voz de Claudia Sheinbaum diciendo cosas como: “es posible que la reforma judicial pueda impactar negativamente las inversiones” o “Cancelar el Aeropuerto en Texcoco fue un error”. También, la herramienta clonó, con total claridad y fidelidad, la voz de Sheinbaum diciendo mensajes racistas, de odio y groserías. Lo mismo fue posible con las voces de Ramírez de la O, Rodríguez Ceja y Taddei Zavala, cada uno al estilo de cada personaje.

En el caso de Speechify, la calidad bajó a pesar de que el discurso en texto proporcionado fue explícitamente igual al que se le proporcionó como muestra en Elevenlabs. Pueden apreciarse problemas de entonación que pudieran interpretarse como “robotizados”.

Para los casos en que se observó mayor fidelidad en los demás discursos, el modelo de Elevenlabs logró replicar acentuación, entonación y sólo en un par de casos replicó la respiración y añadió un suspiro al discurso.

Para la categoría de discursos emotivos, donde se buscó tener un resultado más expresivo, el modelo no pudo replicar emociones en ninguno de los casos a pesar de que el discurso pretendía que lo hiciera. La expresividad que permeó en todas las réplicas fue parecida a la muestra proporcionada, es decir, similares a la lectura de un discurso.

Por otro lado, la velocidad promedio de generación de audio es de entre diez y treinta segundos. No existió una constante en la tardanza de la generación de audios, es decir, el discurso no determinó la latencia de la generación de los audios.

Para la creación de discursos de odio y fake news, no se encontraron filtros de ningún tipo para que el modelo funcionara, tan sólo bastó con escribir el discurso en la ventana de texto. Sin embargo, a medida que se realizaban los audios, el modelo parecía saturarse, lo cual sí incidió en el tiempo de generación de audios o en la calidad de los mismos.

El hallazgo más importante fueron los nulos candados de autenticación para la clonación de voz. Ambos modelos pueden replicar cualquiera de los discursos proporcionados sin tener verificación de voz o del contenido. Arena Pública busco a ElevenLabs y Speechify, pero no obtuvo respuesta inmediata.

Para el experto en Inteligencia Artificial, José Gustavo Fuentes, esta debería ser una de las prioridades para las plataformas de clonación de voz con IA, debido al riesgo que se corre. “Se tiene que repensar la autenticación biométrica para acceder a dichos modelos, y además, deberíamos ser mucho más serios respecto a la legislación en general de inteligencia artificial. Se tiene que legislar porque tiene que ir hacia el bien de la humanidad. Es un arma de doble filo”, expone.

El académico agrega que las herramientas por sí solas no son peligrosas, sin embargo son un arma de réplica de conductas y actividades de las personas, por eso las medidas regulatorias, como las que comienzan a gestarse a nivel internacional, deben ser acompañadas del combate a la desinformación.