Alucinaciones de IA aumentan en temas que no están en Wikipedia

Wikipedia podría tener una influencia importante en los modelos de Inteligencia Artificial. La evaluación de diferentes grandes modelos de lenguaje (LLM) de IA generativa, reveló que incluso los modelos más avanzados, como GPT-4o y GPT-3.5, tienden a alucinar más con conocimientos ajenos a páginas de Wikipedia, según el estudio WILDHALLUCINATIONS: Evaluación de la veracidad de los textos extensos en los LLM con consultas de entidades del mundo real, realizado por investigadores de Cornell, la Universidad de Washington, la Universidad de Waterloo y el instituto sin fines de lucro AI2.

Los chatbots de IA enfrentan desafíos para lograr precisión en sus respuestas, y uno de sus errores más característicos son las alucinaciones. Las alucinaciones se refieren a la generación de información incorrecta, inexacta o inventada por modelos de inteligencia artificial, especialmente los modelos de lenguaje generativos.

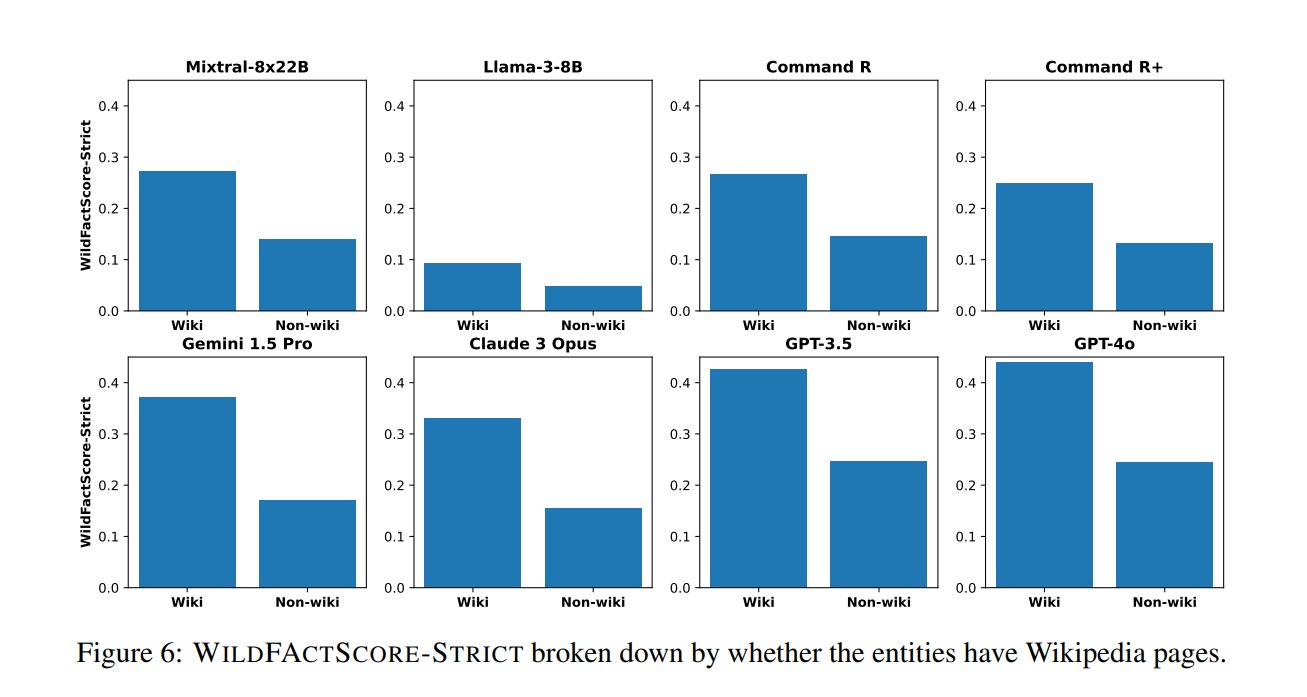

En ese sentido, el análisis comparó la veracidad de las respuestas de los modelos de lenguaje a preguntas sobre temas diversos, con y sin fuentes de Wikipedia. Los resultados, muestran que todos los modelos tienden a presentar una menor precisión factual, es decir cuán correctamente el modelo refleja la verdad o la realidad en sus respuestas, al generar información basada en fuentes distintas a Wikipedia.

El estudio que analizó modelos como GPT-3.5, GPT-4o, el más reciente modelo de OpenAI, Claude 3 Opus, Gemini 1.5 Pro, Llama-3-8B, entre otros, reflejó en los casos en los que la fuente de una respuesta no era Wikipedia, todos los modelos respondieron con menos hechos en promedio (pero especialmente GPT-3.5 y GPT-4o), lo que sugiere que todos están fuertemente informados por el contenido de Wikipedia.

Incluso los modelos que pueden buscar información en la web, como Command R y los modelos Sonar de Perplexity, tuvieron dificultades con las preguntas "no wiki" en la prueba comparativa.

Una investigación del periódico New York Times anticipó esta influencia, asegurando que Wikipedia podría representar entre el 3 y el 5% de los datos extraídos que un LLM usa para su entrenamiento. "Wikipedia en el futuro siempre será muy valiosa porque es uno de los conjuntos de datos más grandes y bien curados que existen", dijo Jesse Dodge, científico informático del Instituto Allen para IA en Seattle, citado por el periódico.

En general, hay una relación entre la calidad de los datos utilizados para entrenar un modelo y la precisión y coherencia de las respuestas que este ofrece, señaló el científico en ese momento.

Es posible que la precisión de la información en Wikipedia esté ligada a que la mayoría de los artículos incluyen notas a pie de página, enlaces a las fuentes originales y listas de ediciones y editores previos. Además, Wikipedia exige que sus editores mantengan un "punto de vista neutral", o corren el riesgo de que sus contribuciones sean revertidas. La plataforma también se autoexamina continuamente.

Sin embargo, los LLM tienen dificultades al procesar la información. La dificultad para lograr precisión radica en su funcionamiento probabilístico al generar texto. "Estos modelos están diseñados para producir texto que suene natural, no necesariamente para ser veraces", señala el New York Times.

Además, señala que la factualidad debería ser una prioridad fundamental para la IA. Sin embargo, las grandes empresas, en su frenética competencia, a menudo priorizan la introducción de productos sobre la confiabilidad.

Sin embargo, el entrenamiento con información proveniente de Wikipedia desata otras preocupaciones, como la réplica de desinformación, una práctica común en la llamada enciclopedia en línea.

Pero las preocupaciones no sólo giran en torno a estos desafíos, pues el estudio refuerza la idea de que la veracidad de los modelos de IA generativa sigue siendo una tarea pendiente , debido a que aunque algunos modelos pueden parecer más precisos, la realidad es que todos los modelos pueden generar alucinaciones.

La solución a este problema no es sencilla. Los proveedores de modelos de IA deben dedicar más esfuerzos a la investigación y al desarrollo de herramientas avanzadas de verificación de datos, así como a la implementación de políticas que aseguren la participación de expertos humanos en la validación de la información generada por los modelos, dijo para TechCrunch Wenting Zhao, estudiante de doctorado en Cornell y coautor de la investigación.