IA y seguridad: ¿estamos preparados?

Con el acelerado progreso de la inteligencia artificial (IA) se avanza hacia nuevas dinámicas económicas y sociales, pero también a riesgos significativos: seguridad, privacidad, sesgos algorítmicos, desinformación y, en el extremo más inquietante, amenazas existenciales. Ante este panorama, el Global Index for AI Safety (GIAIS) surge como un intento de medir la preparación de los países frente a estos desafíos. Pero ¿realmente estamos avanzando en la dirección correcta?

El informe, desarrollado bajo el AGILE Index (AI Governance International Evaluation Index), evalúa a 40 países según seis pilares clave: gobernanza, infraestructura institucional, regulaciones, investigación, cooperación internacional y mitigación de riesgos existenciales. En términos generales, países desarrollados como Estados Unidos, Reino Unido y China lideran el ranking, con mejores estructuras regulatorias y una mayor participación en iniciativas globales, mientras que las economías emergentes se enfrentan a mayores desafíos. México aparece en el lugar 33 muy por detrás de países latinoamericanos como Argentina y Brasil.

Sin embargo, un análisis crítico de este ranking plantea una cuestión fundamental: el hecho de que un país tenga leyes o instituciones dedicadas a la seguridad en IA no implica necesariamente que estas sean efectivas o suficientes. ¿Acaso tener más regulaciones es sinónimo de mayor seguridad? O, como tantas veces ocurre, ¿son simplemente un formalismo que no se traduce en prácticas tangibles?

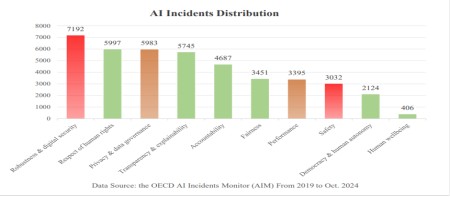

Uno de los hallazgos más relevantes del informe es que sólo 17 de los 40 países analizados han implementado leyes o marcos regulatorios específicos para la seguridad en IA. Aún más preocupante es que estas regulaciones suelen centrarse en aspectos generales de ciberseguridad o protección de datos, dejando de lado los problemas específicos de la IA, como la explicabilidad de los modelos, la auditoría de algoritmos y la gobernanza de datos.

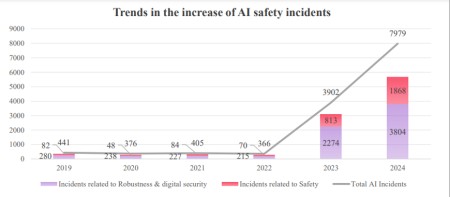

Un ejemplo de esta desconexión es el creciente número de incidentes de seguridad en IA, que ha aumentado un 83.7% entre 2023 y 2024 según el informe. Este dato nos dice dos cosas: primero, que los marcos existentes no están funcionando; segundo, que la regulación no está avanzando a la misma velocidad que el desarrollo tecnológico. ¿De qué sirve promulgar leyes cuando las empresas tecnológicas las superan con nuevos modelos más potentes antes de que puedan ser implementadas?

El estudio también resalta un incremento significativo en la investigación sobre seguridad en IA, con Estados Unidos y China concentrando más del 50% de las publicaciones científicas en el tema. Este dato, aunque positivo, también evidencia una preocupante centralización del conocimiento en pocas manos. Mientras que algunos países han fortalecido sus capacidades investigativas, otros simplemente no tienen los recursos para hacerlo, lo que genera una brecha de seguridad global donde unos pocos controlan las soluciones y el resto depende de ellas.

La participación internacional también deja mucho que desear. Si bien existen esfuerzos como la Declaración de Bletchley (2023) y la Cumbre de IA en Seúl (2024), la realidad es que la cooperación sigue siendo insuficiente. Como destaca el informe, "ningún país puede enfrentar solo los desafíos de la seguridad en IA", pero aun así siguen existiendo barreras geopolíticas y comerciales que dificultan un verdadero esfuerzo global.

Uno de los puntos más preocupantes del informe es la falta de preparación para los riesgos existenciales de la IA. Si bien el tema ha sido objeto de discusión en foros académicos y de investigación, en la práctica, ni los gobiernos ni la industria han desarrollado estrategias concretas para mitigar estos riesgos a largo plazo.

Según el estudio, ninguna de las principales empresas de IA obtiene calificaciones aceptables en estrategias de seguridad existencial. Empresas como OpenAI, Google DeepMind y Meta reciben puntuaciones deficientes, lo que indica una falta de planificación para el impacto a largo plazo de sus tecnologías. Esto es especialmente alarmante cuando consideramos que son precisamente estas empresas las que lideran el desarrollo de modelos cada vez más potentes.

A partir de los hallazgos del informe, es evidente que la seguridad en IA necesita un enfoque más holístico, inclusivo y proactivo. Algunas recomendaciones clave incluyen:

- Regulaciones flexibles y actualizables: Las leyes deben ser más adaptables para no quedar obsoletas rápidamente ante nuevos avances tecnológicos.

- Mayor inversión en investigación: La seguridad en IA no puede ser una preocupación exclusiva de unas pocas potencias; los países en desarrollo también deben contar con recursos para avanzar en esta área.

- Un verdadero esfuerzo global: Es necesario un mayor compromiso internacional que trascienda intereses económicos y geopolíticos.

- Conciencia y educación sobre IA segura: Empresas, gobiernos y sociedad civil deben estar informados y preparados para abordar los riesgos de la IA de manera responsable.

La conclusión es que estamos avanzando, pero a un ritmo insuficiente. El Global Index for AI Safety nos da un panorama claro: si bien existen avances, estos son escasos, desiguales y lentos en comparación con la velocidad de innovación tecnológica. La regulación no está alcanzando el ritmo de la evolución de la IA, la cooperación internacional sigue siendo limitada y las estrategias para abordar riesgos existenciales brillan por su ausencia.

Nos encontramos en un punto crucial. La seguridad en IA no es un lujo ni un obstáculo para la innovación, sino una necesidad fundamental para garantizar que la tecnología beneficie a toda la humanidad sin comprometer nuestra estabilidad y seguridad. La pregunta ahora no es si debemos actuar, sino cuánto tiempo nos queda antes de que sea demasiado tarde.

Referencia de interés

Global Index for AI Safety AGILE Index on Global AI Safety Readiness Feb 2025

Claudia Jiménez

Politóloga e Internacionalista en temas de cooperación internacional y derechos humanos en América Latina, con 20 años de experiencia en consultorías nacionales y gobierno.

Profesora universitaria y conferencista. Desarrolladora de cursos y proyectos de tecnología y ética para la academia y empresas. Catedrática de la Escuela de Ciencias Sociales y Gobierno, y de Estudios Humanísticos y Educación del Tecnológico de Monterrey. Pionera en Inteligencia Artificial en educación.

Claudia Jiménez

Politóloga e Internacionalista en temas de cooperación internacional y derechos humanos en América Latina, con 20 años de experiencia en consultorías nacionales y gobierno.

Profesora universitaria y conferencista. Desarrolladora de cursos y proyectos de tecnología y ética para la academia y empresas. Catedrática de la Escuela de Ciencias Sociales y Gobierno, y de Estudios Humanísticos y Educación del Tecnológico de Monterrey. Pionera en Inteligencia Artificial en educación.