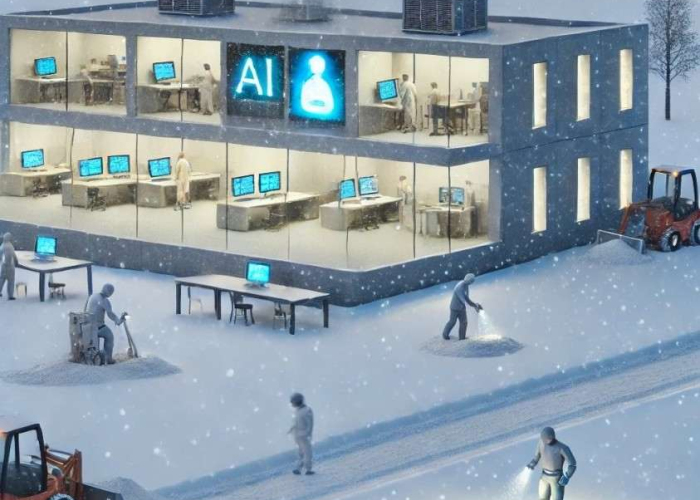

¿Se viene el tercer invierno de la Inteligencia Artificial?

La historia de la inteligencia artificial (IA), ha estado marcada por picos de expectativas exageradas, seguidos por una serie de altibajos constantes. Desde los 'inviernos de la IA' de las décadas de 1970 y 1980 hasta hoy, hemos visto ciclos de auge seguidos de caídas extremas.

Un caso emblemático fue lo que sucedió con IBM en 2011 que prometía que su sistema “Watson” podría transformar rápidamente sectores como la salud, la banca, la ciberseguridad y la investigación científica. Sin embargo, estas expectativas no siempre se alinearon con la realidad y los resultados fueron muy limitados y desaceleraron el interés por la IA y los cambios estratégicos.

Recientemente, el desarrollo de sistemas de IA generativa ha suscitado dudas sobre sus capacidades y potencial, reavivando la idea de que podamos estar al borde de otro "invierno" de la IA. Este término "Invierno de la Inteligencia Artificial" surgió en 1984 de la mano de Roger Schank y Marvin Minsky como una metáfora para un tiempo de estancamiento en el área, debido a la retirada de fondos e interés en la disciplina.

Esta noción, inspirada en la idea del "invierno nuclear" de la Guerra Fría, simboliza un momento de fracaso tras un periodo de grandes expectativas sobre las capacidades de la IA. A lo largo de décadas, han existido varios de estos inviernos, caracterizados por ciclos de expectativas infladas, decepciones tecnológicas y recortes financieros.

Estos años, aunque difíciles, estuvieron plagados de lecciones. Nos mostraron la importancia de ser realistas en la evaluación tanto de las capacidades de la IA como de las circunstancias bajo las cuales es necesario priorizar la investigación básica. El objetivo es gestionar el entusiasmo, no intentar escapar de él, para evitar caer en la exageración. También es fundamental ser claros al comunicar a inversores, responsables políticos y al público para que sus expectativas se ajusten a la realidad tecnológica.

Entonces, la pregunta que planteo es ¿nos dirigimos hacia otro invierno de la IA?

A pesar de los logros recientes, hay señales de que podríamos estar al borde de otro "invierno" de la IA. Parece que, en estos últimos meses, este impulso hacia adelante en la IA se ha desacelerado, especialmente en los desarrollos de IA generativa, después de un año récord en 2023 e inicios de 2024. La realidad es que sistemas como GPT-4, aunque impresionantes, no han cumplido completamente las promesas hechas a los inversores y enfrentan el desafío de las "alucinaciones" (errores en la generación de contenido) y una falta de comprensión genuina del contexto. Esto podría ser seguido por una nueva ola de escepticismo debido a estas razones y a la creciente preocupación sobre el uso ético de la tecnología.

Pero no todo es pesimismo. Los modelos de código abierto que están en auge y la diversificación de aplicaciones de la IA en diferentes sectores garantizan que la tecnología aún no ha alcanzado su pico. La inversión en IA no se detiene; en cambio, se dirige hacia nuevas áreas de innovación, lo que indica una posible adaptación en lugar de un declive.

Para hacer frente a estos desafíos sería necesario transformar la narrativa y replantear la forma en la que la tecnología está más que nunca cambiando el “mindset” del humanismo sobre todo en tres enfoques clave:

- La promoción de la integración ética y responsable de la IA en el entorno laboral. La IA está transformando el mercado, automatiza tareas repetitivas y redefine roles. Según varios estudios a nivel mundial, los trabajos que contienen análisis de datos, traducciones, call centers, auditorías, entre algunos, están en peligro de ser asumidos por sistemas de IA. En este sentido, una transición justa debe incluir programas de reentrenamiento y aprendizaje permanente para que los trabajadores puedan desarrollar habilidades creativas, analíticas y emocionales en nuevas funciones.

- La adopción de una estrategia de innovación sostenible. Una y otra vez, las empresas y los gobiernos buscan soluciones rápidas: innovaciones que generen beneficios inmediatos, sin tener en cuenta las limitaciones técnicas y los posibles efectos secundarios de la tecnología. Lo que se necesita es un enfoque mucho más cauteloso y estratégico, que incluya trabajo en investigación fundamental y la creación de aplicaciones de IA que sean útiles y viables a largo plazo. No debemos repetir los errores del pasado permitiendo que los sistemas expertos, entre otros proyectos muy ambiciosos, fracasen bajo expectativas infladas y no puedan manejar entradas inesperadas.

- El fomento a la transparencia y la colaboración interdisciplinaria. La IA no debe permanecer como un dominio exclusivo para tecnólogos. El desarrollo de estos sistemas debe ser multidisciplinario. Esto hará que el proceso de construir tales sistemas sea más robusto y humano al incluir expertos de otros campos, como ética, sociología, etnología, economía y psicología. Además, la transparencia en el desarrollo y uso de la IA es clave para mantener la confianza del público y los inversores. Las empresas e investigadores también deben ser más abiertos sobre las capacidades y limitaciones de estos sistemas, los riesgos involucrados y los esfuerzos realizados para mitigarlos.

Por lo tanto, para prevenir otro "invierno" y aprovecharlo para el bien de la humanidad, se requiere un cambio de perspectiva en cómo la sociedad, las empresas y los gobiernos ven la IA. Algunas propuestas concretas podrían incluir:

- Complementar las habilidades humanas. El aumento de la IA en los lugares de trabajo no debe verse como una amenaza, sino como una oportunidad para enfatizar las habilidades humanas únicas que las máquinas no pueden imitar bien, como el pensamiento crítico, la empatía y la creatividad. Los sistemas educativos y de formación profesional deben adaptarse para preparar a las personas para un futuro mercado laboral donde trabajarán con la IA, no en competencia con ella.

- Impulsar la investigación en ética y regulación. A medida que la IA se convierte en parte integral de nuestras vidas, la investigación en ética de la IA y la política pública deben avanzar al mismo ritmo. Las regulaciones deben ser dinámicamente flexibles para permitir la innovación, pero mantenerse lo suficientemente estrictas para proteger a los ciudadanos de posibles abusos y daños. Se requiere un marco global para establecer claramente las normas para el desarrollo y uso de la IA.

- Promover la innovación abierta y la colaboración. La comunidad de IA debe aprender de los errores del pasado y adoptar una cultura de innovación abierta a través del intercambio de conocimientos, datos y tecnología. Esto garantiza que los beneficios de la IA sean democráticos y accesibles. Iniciativas como los proyectos de código abierto y las colaboraciones intersectoriales pueden ayudar a distribuir los beneficios y mitigar los riesgos asociados con la concentración de tecnología.

La historia de la IA ofrece una oportunidad para aprender y crecer. Una perspectiva crítica y constructiva es vital para evitar repetir errores pasados y avanzar hacia un futuro donde la IA sea una fuerza de transformación positiva. La innovación tecnológica debe ir acompañada de responsabilidad ética, transparencia y una visión inclusiva del impacto de la IA en la sociedad. En lugar de temer otro "invierno", debemos prepararnos para una nueva primavera de la inteligencia artificial, donde el crecimiento sea sostenible y los beneficios se compartan equitativamente.

Referencias de interés:

Claudia Jiménez

Politóloga e Internacionalista en temas de cooperación internacional y derechos humanos en América Latina, con 20 años de experiencia en consultorías nacionales y gobierno.

Profesora universitaria y conferencista. Desarrolladora de cursos y proyectos de tecnología y ética para la academia y empresas. Catedrática de la Escuela de Ciencias Sociales y Gobierno, y de Estudios Humanísticos y Educación del Tecnológico de Monterrey. Pionera en Inteligencia Artificial en educación.

Claudia Jiménez

Politóloga e Internacionalista en temas de cooperación internacional y derechos humanos en América Latina, con 20 años de experiencia en consultorías nacionales y gobierno.

Profesora universitaria y conferencista. Desarrolladora de cursos y proyectos de tecnología y ética para la academia y empresas. Catedrática de la Escuela de Ciencias Sociales y Gobierno, y de Estudios Humanísticos y Educación del Tecnológico de Monterrey. Pionera en Inteligencia Artificial en educación.