Presenta Nvidia nuevo chip en medio de la carrera de la IA

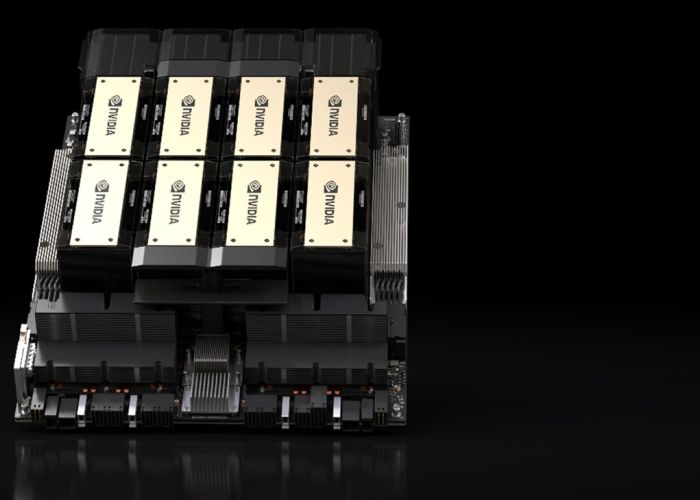

Nvidia ha dado un paso significativo en el ámbito de la inteligencia artificial (IA) con el lanzamiento de su última creación: el chip HGX H200. Diseñado específicamente para el entrenamiento y despliegue de modelos de IA, este GPU representa una evolución respecto a su predecesor, el H100, utilizado por OpenAI en el entrenamiento del revolucionario modelo de lenguaje GPT-4.

El H200 destaca por su avance en memoria, incorporando 141 GB de la nueva generación HBM3. Esta mejora facilita la inferencia, la gestión de modelos grandes después de su entrenamiento para generar texto, imágenes o predicciones. Nvidia asegura que esta GPU ofrecerá resultados casi el doble de rápido que su predecesor, basándose en pruebas con el Llama 2 LLM de Meta.

El gigante tecnológico también confirmó la compatibilidad del H200 con el H100, lo que implica que las empresas que ya están utilizando el modelo anterior no tendrán que realizar cambios en sus sistemas de servidor o software para adoptar la nueva versión. La disponibilidad del H200 se extenderá a configuraciones de servidor con cuatro u ocho GPU en los sistemas HGX completos de la compañía. Además, la empresa presentará un chip denominado GH200, una combinación que integra la GPU H200 con un procesador basado en ARM.

La fecha de lanzamiento, proyectada para el segundo trimestre de 2024, coloca al H200 en directa competencia con la GPU MI300X de AMD. Esta última, con su memoria adicional, ofrece un rendimiento destacado en la ejecución de inferencias en modelos grandes, planteando así un desafío para que el H200 mantenga su posición como la GPU de IA más rápida de Nvidia.

AMD se ha posicionado como una de las empresas pioneras desarrolladoras en este sector, y ha elevado su perfil considerablemente. Durante su último reporte trimestral, la empresa vislumbró un pronóstico optimista de ventas de chips de inteligencia artificial. Este anuncio llevó a un aumento del 8% en las acciones de AMD, indicando un avance significativo en su intento por alcanzar al líder del mercado, Nvidia.

La directora ejecutiva de AMD, Lisa Su, proyectó ventas anuales de más de 2.000 millones de dólares para los chips MI300, diseñados para competir con los avanzados chips H100 de Nvidia. Esta proyección convertiría al MI300 en el producto más rápido en alcanzar mil millones de dólares en ventas en la historia de AMD.

Su también anunció compromisos de "múltiples grandes clientes de hiperescala", fortaleciendo la posición de AMD en el mercado de aceleradores de IA. Aunque las acciones de AMD han aumentado un 61% este año, el pronóstico conservador y la debilidad en varios mercados llevaron a algunos analistas a recortar objetivos de precios para las acciones.

Por su parte, en octubre, Nvidia anunció un cambio hacia un patrón de lanzamiento anual debido a la alta demanda de sus GPU. Además, la compañía proyecta lanzar el chip B100, basado en la próxima arquitectura Blackwell, en 2024.

Intel también ha entrado con fuerza en la carrera de la inteligencia artificial. Durante el evento Intel Innovation 2023, en octubre, el director ejecutivo, Pat Gelsinger, reveló una serie de procesadores, unidades gráficas y de red que la compañía lanzará entre 2023 y 2024, poniendo especial énfasis en la inteligencia artificial.

Gelsinger destacó el compromiso de Intel en abordar todas las fases de la inteligencia artificial, incluyendo la IA generativa y los grandes modelos de lenguaje. Además, anunció el lanzamiento del procesador Intel Core Ultra, con una unidad de procesamiento neural dedicada a tareas de inteligencia artificial, previsto para diciembre de 2024.

Esta competencia tiene un sentido en común, la inversión en IA que podría catalizar las innovaciones aún más de lo ya visto este año. AMD ha anunciado un evento dedicado a la IA para el próximo seis de noviembre, en el que podría anunciar desarrollos que podrían competir con los últimos anuncios de Nvidia.